-

1 ЦОД

1) General subject: data center (сокр. от "центр обработки данных"; Центр выполняет функции обработки, хранения и распространения информации, как правило, в интересах корпоративных клиентов. ЦОД ориентирован в первую очередь на решени)2) Mining: final separation unit (цех окончательной доводки)3) Information technology: DPC (data processing center, data center)4) Sakhalin energy glossary: Центр обеспечения деятельности5) Automation: digital optical disk -

2 ЦОД

сокр. от центр обработки данных -

3 = ЦОД

sector de acabamento final, picagem (f) (miner.)Русско-португальский словарь терминов металлургии, горных работ и геологии > = ЦОД

-

4 ЦОД

sector de acabamento final, picagem (f) (miner.)Русско-португальский словарь терминов металлургии, горных работ и геологии > ЦОД

-

5 стандарт на телекоммуникационную инфраструктуру центров обработки данных (ЦОД)

стандарт на телекоммуникационную инфраструктуру центров обработки данных (ЦОД)

-

[Интент]Стандарт TIA/EIA-942

Ассоциация TIA завершает разработку стандарта на телекоммуникационную инфраструктуру ЦОД—TIA/EIA-942 (Telecommunications Infrustructure Standard for Data Centers), который, по всей вероятности, будет опубликован в начале 2005 г. Основная цель данного стандарта — предоставить разработчикам исчерпывающую информацию о проектировании инфраструктуры ЦОД, в том числе сведения о планировке его помещений и структуре кабельной системы. Он призван способствовать взаимодействию архитекторов, инженеров-строителей и телекоммуникационных инженеров.

Помимо рекомендаций по проектированию, в стандарте содержатся приложения с информацией по широкому кругу тем, связанных с организацией ЦОД. Вот некоторые из них: выбор места для развертывания ЦОД; администрирование его кабельной системы; архитектурные вопросы; обеспечение безопасности и защита от огня; электрические, заземляющие и механические системы; взаимодействие с операторами сетей общего пользования.

Кроме того, в спецификациях стандарта отражены принятые в отрасли уровни надежности ЦОД. Уровень 1 обозначает отсутствие резервирования подсистем, а значит, низкую степень отказоустойчивости, а уровень 4 — высочайшую степень отказоустойчивости.

Стандарт TIA/EIA-942 определяет ЦОД как здание или его часть, предназначенные для организации компьютерного зала и необходимых для функционирования последнего вспомогательных служб. Компьютерный зал — это часть ЦОД, основным предназначением которой является размещение оборудования обработки данных.

В стандарте обозначены требования к компьютерному залу и комнатам для ввода кабелей (от сетей общего пользования). Так, для этих помещений определены: высота потолка (2,6 м); покрытие полов и стен; характеристики освещения; нагрузка на полы (минимальная — 732 кг/м2, рекомендуемая — 1220 кг/м2); параметры систем нагревания, вентиляции и кондиционирования воздуха; температура воздуха (20—25 °С), относительная влажность (40—55%); характеристики систем электропитания, заземления и противопожарной защиты.

В число телекоммуникационных помещений и участков ЦОД входят:

• Комната для ввода кабелей.

• Главный распределительный пункт (Main Distribution Area — MDA).

• Распределительный пункт горизонтальной подсистемы кабельной системы ЦОД (Horizontal Distribution Area — HDA).

• Распределительный пункт зоны (Zone Distribution Area — ZDA).

• Распределительный пункт оборудования (Equipment Distribution Area — EDA).

Комната для ввода кабелей — это помещение, в котором кабельная система ЦОД соединяется с кабельными системами кампуса и операторов сетей общего пользования. Она может находиться как снаружи, так и внутри компьютерного зала. При организации соединения названных кабельных систем внутри компьютерного зала соответствующие средства можно оборудовать в MDA.

С целью резервирования элементов инфраструктуры ЦОД или соблюдения ограничений на максимальную длину каналов связи в ЦОД можно организовать несколько комнат для ввода кабелей. Например, максимальная длина канала T-1, как правило, не должна превышать 200 м, тогда как типичное ограничение на длину канала T-3 составляет 137 м. Однако использование тех или иных типов кабеля и промежуточных коммутационных панелей в ряде случаев суще-ственно уменьшает максимально допустимую длину линии. В стандарте TIA/EIA-942 имеются рекомендации по максимальной длине кабельных каналов в ЦОД.

MDA содержит главный кросс, являющийся центром коммутации каналов кабельной системы ЦОД. В помещении MDA могут находиться и горизонтальные кроссы, предназначенные для коммутации горизонтальных кабелей, идущих к оборудованию, которое напрямую взаимодействует с оборудованием MDA. Кроме того, в помещении MDA обычно устанавливают маршрутизаторы и магистральные коммутаторы локальной сети и сети SAN ЦОД. Согласно стандарту, ЦОД должен иметь по крайней мере один MDA, а в целях резервирования допускается организация второго MDA.

Помещение HDA предназначено для установки горизонтального кросса, с помощью которого осуществляется коммутация горизонтальных кабелей, идущих к оборудованию EDA, а также переключателей KVM и коммутаторов ЛВС и SAN, взаимодействующих с оборудованием HDA.

ZDA — факультативный элемент горизонтальной подсистемы, располагающийся между HDA и EDA. Он призван обеспечить гибкость реконфигурации этой подсистемы. В ZDA горизонтальные кабели терминируются в зоновых розетках или точках консолидации. Подключение оборудования к зоновым розеткам осуществляется посредством соединительных кабелей. Стандарт не рекомендует размещать в ZDA коммутационную панель или активное оборудование, за исключением устройств подачи электропитания по горизонтальным кабелям.

EDA — это участок ЦОД, выделенный для размещения оконечного оборудования, в том числе компьютеров и телекоммуникационных устройств. В EDA горизонтальные кабели терминируются на розетках, которые обычно располагают на коммутационных панелях, устанавливаемых в монтажных стойках или шкафах. Стандартом допускается и соединение устройств EDA напрямую друг с другом (например, blade-серверы могут напрямую подключаться к коммутаторам, а обычные серверы — к периферийным устройствам).

В составе ЦОД вне пределов компьютерного зала можно оборудовать телекоммуникационную комнату, предназначенную для поддержки горизонтальных кабелей, проложенных к офисам обслуживающего персонала, центру управления, помещениям с механическим и электрическим оборудованием и другим помещениям или участкам ЦОД, расположенным вне стен компьютерного зала. Типичный ЦОД имеет одну или две комнаты для ввода кабелей, одну или несколько телекоммуникационных комнат, один MDA и несколько HDA.

Кабельная система ЦОД состоит из следующих элементов:

• горизонтальная подсистема;

• магистральная подсистема;

• входной кросс, находящийся в комнате для ввода кабелей или в помещении MDA (если комната ввода кабелей объединена с MDA);

• главный кросс, установленный в MDA;

• горизонтальный кросс, размещенный в HDA, MDA или в телекоммуникационной комнате;

• зоновая розетка или точка консолидации, смонтированная в ZDA;

• розетка, установленная в EDA.

Горизонтальная подсистема — это часть кабельной системы ЦОД, проходящая между розеткой в EDA (или зоновой розеткой в ZDA) и горизонтальным кроссом, который находится в HDA или MDA. В состав горизонтальной подсистемы может входить факультативная точка консолидации. Магистральная подсистема связывает MDA с HDA, телекоммуникационными комнатами и комнатами для ввода кабелей.

Горизонтальная и магистральная подсистемы кабельной системы ЦОД имеют топологию типа “звезда”. Горизонтальные кабели подключаются к горизонтальному кроссу в HDA или MDA. С целью резервирования путей передачи данных разные розетки в EDA или ZDA можно соединять (горизонтальными кабелями) с разными горизонтальными кроссами.

В звездообразной топологии магистральной подсистемы каждый горизонтальный кросс, расположенный в HDA, подключен напрямую к главному кроссу в MDA. Промежуточных кроссов в кабельной инфраструктуре ЦОД не предусмотрено.

Чтобы повысить надежность работы инфраструктуры, как уже отмечалось, допускается резервирование HDA. В этом случае все горизонтальные кроссы должны быть связаны с основным и резервным HDA.

Стоит также отметить, что для резервирования элементов инфраструктуры и поддержки приложений, которые не могут функционировать из-за того, что длина путей передачи данных в рамках звездообразной топологии превышает максимальную дальность связи с использованием этих приложений, допускается организация прямых кабельных соединений между HDA. Кроме того, для соблюдения ограничений на максимальную длину кабельных каналов разрешено организовывать прямые соединения между второй комнатой для ввода кабелей и помещениями HDA.

Для поддержки разнообразных приложений стандарт TIA/EIA-942 допускает установку самых разных типов кабелей, но при этом в новых инсталляциях рекомендует использовать кабели с максимально широкой полосой пропускания. Это весьма значительно увеличивает возможный срок службы кабельной инфраструктуры ЦОД.

К разрешенным стандартом типам кабелей относятся:

• 100-Ом кабель из витых пар, соответствующий стандарту ANSI/TIA/EIA-568-B.2; рекомендуется использовать кабель категории 6, специфицированный в приложении ANSI/TIA/EIA-568-B.2-1.

• Кабель с 62,5/125-мкм или 50/125-мкм многомодовым волокном, соответствующий стандарту ANSI/TIA/EIA-568-B.3; рекомендуется использовать 50/125-мкм многомодовое волокно, оптимизированное для работы с 850-нм лазером и специфицированное в документе ANSI/TIA-568-B.3-1.

• Одномодовый оптоволоконный кабель стандарта ANSI/TIA/EIA-568-B.3.

• 75-Ом коаксиальный кабель (типа 734 или 735), соответствующий документу GR-139-CORE фирмы Telcordia Technologies, и коаксиальные разъемы стандарта ANSI T1.404. Эти кабели и разъемы рекомендованы для организации каналов T-3, E-1 и E-3.

Прокладка кабелей и размещение оборудования

Для прокладки кабелей в ЦОД стандарт TIA/EIA-942 разрешает использовать самые разные полости и конструкции, включая пространство под фальшполом и верхние кабельные лотки, уже получившие широкое распространение в ЦОД. Стандарт рекомендует реализовывать фальшполы в тех ЦОД, где предполагается высокая концентрация оборудования с большим энергопотреблением, или устанавливать большую компьютерную систему, сконструированную для подвода кабелей снизу. Под фальшполом телекоммуникационные кабели следует размещать в кабельных лотках, причем они не должны мешать потоку воздуха и иметь острых краев.

Верхние кабельные лотки стандарт рекомендует подвешивать к потолку, а не прикреплять их к верхним частям монтажных стоек или шкафов. Это обеспечивает большую гибкость применения монтажного оборудования разной высоты. И еще. Размещать осветительные приборы и водораспыляющие головки нужно в проходах между рядами стоек или шкафов с оборудованием, а не прямо над ними.

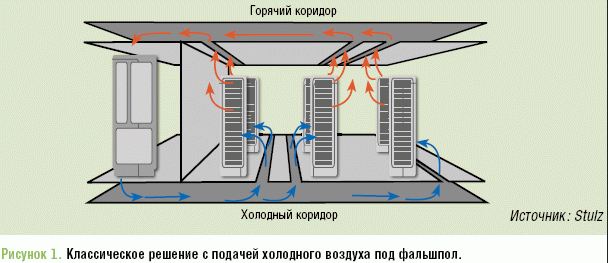

Согласно стандарту, для организации так называемых холодных и горячих проходов между рядами стоек или шкафов с оборудованием их следует устанавливать таким образом, чтобы стойки или шкафы соседних рядов были обращены либо передними, либо задними сторонами друг к другу. Холодные проходы образуются впереди стоек или шкафов — в этих проходах плиты фальшпола имеют отверстия, через которые в помещение ЦОД поступает холодный воздух. Силовые кабели обычно прокладывают под холодными проходами. Соседние с ними проходы называются горячими — в ту сторону обращены задние части шкафов или стоек. Лотки с телекоммуникационными кабелями, как правило, располагают под горячими проходами.

В стойках или шкафах оборудование должно быть смонтировано так, чтобы его вентиляционные отверстия, через которые всасывается холодный воздух, находились в передней части шкафа или стойки, а выход горячего воздуха осуществлялся в задней части. В противном случае система охлаждения оборудования, основанная на концепции холодных и горячих проходов, не будет работать. Данная концепция ориентирована на устройства, в которых охлаждающий воздух перемещается от передней панели к задней.

Чтобы обеспечивать надлежащее охлаждение установленного оборудования, монтажные шкафы должны иметь средства воздухообмена. Если шкафы не оснащены вентиляторами, способствующими более эффективному функционированию горячих и холодных проходов, то в дверях шкафов должно быть большое число вентиляционных отверстий или прорезей, общая площадь которых составляла бы не менее половины площади двери.

Для удобства монтажа оборудования и прокладки кабелей проходы между рядами шкафов или стоек не должны быть слишком узкими. Рекомендуемое расстояние между передними сторонами стоек или шкафов (соседних рядов) — 1,2 м, а минимальное — 0,9 м. Расстояние между задними сторонами стоек или шкафов (опять же соседних рядов) должно составлять 0,9 м, а минимальное — 0,6 м.

Размещать ряды стоек или шкафов нужно так, чтобы можно было снимать плиты фальшпола спереди и сзади ряда. Таким образом, все шкафы следует выравнивать вдоль краев плит фальшпола. Чтобы резьбовые стержни, которыми монтажные стойки крепятся к межэтажным перекрытиям, не попадали на крепежные элементы плит фальшпола, стойки устанавливаются ближе к центру этих плит.

Размеры прорезей в плитах фальшпола, находящихся под стойками или шкафами, должны быть не больше, чем это необходимо, чтобы свести к минимуму снижение давления воздуха под фальшполом. Кроме того, для минимизации продольной электромагнитной связи между силовыми и телекоммуникационными кабелями из витых пар в стандарте TIA/EIA-942 оговорены требования к расстоянию между ними.

Стандарт TIA/EIA-942 разрабатывается с целью удовлетворения потребности ИТ-отрасли в рекомендациях по проектированию инфраструктуры для любого ЦОД независимо от его размеров (небольшой, средний или крупный) и характера использования (корпоративный ЦОД или ЦОД, в котором базируются Интернет-серверы разных компаний).

[ http://www.ccc.ru/magazine/depot/04_13/read.html?1102.htm]

Тематики

EN

Русско-английский словарь нормативно-технической терминологии > стандарт на телекоммуникационную инфраструктуру центров обработки данных (ЦОД)

-

6 модульный центр обработки данных (ЦОД)

модульный центр обработки данных (ЦОД)

-

[Интент]Параллельные тексты EN-RU

[ http://dcnt.ru/?p=9299#more-9299]

Data Centers are a hot topic these days. No matter where you look, this once obscure aspect of infrastructure is getting a lot of attention. For years, there have been cost pressures on IT operations and this, when the need for modern capacity is greater than ever, has thrust data centers into the spotlight. Server and rack density continues to rise, placing DC professionals and businesses in tighter and tougher situations while they struggle to manage their IT environments. And now hyper-scale cloud infrastructure is taking traditional technologies to limits never explored before and focusing the imagination of the IT industry on new possibilities.

В настоящее время центры обработки данных являются широко обсуждаемой темой. Куда ни посмотришь, этот некогда малоизвестный аспект инфраструктуры привлекает все больше внимания. Годами ИТ-отделы испытывали нехватку средств и это выдвинуло ЦОДы в центр внимания, в то время, когда необходимость в современных ЦОДах стала как никогда высокой. Плотность серверов и стоек продолжают расти, все больше усложняя ситуацию для специалистов в области охлаждения и организаций в их попытках управлять своими ИТ-средами. И теперь гипермасштабируемая облачная инфраструктура подвергает традиционные технологии невиданным ранее нагрузкам, и заставляет ИТ-индустрию искать новые возможности.

At Microsoft, we have focused a lot of thought and research around how to best operate and maintain our global infrastructure and we want to share those learnings. While obviously there are some aspects that we keep to ourselves, we have shared how we operate facilities daily, our technologies and methodologies, and, most importantly, how we monitor and manage our facilities. Whether it’s speaking at industry events, inviting customers to our “Microsoft data center conferences” held in our data centers, or through other media like blogging and white papers, we believe sharing best practices is paramount and will drive the industry forward. So in that vein, we have some interesting news to share.

В компании MicroSoft уделяют большое внимание изучению наилучших методов эксплуатации и технического обслуживания своей глобальной инфраструктуры и делятся результатами своих исследований. И хотя мы, конечно, не раскрываем некоторые аспекты своих исследований, мы делимся повседневным опытом эксплуатации дата-центров, своими технологиями и методологиями и, что важнее всего, методами контроля и управления своими объектами. Будь то доклады на отраслевых событиях, приглашение клиентов на наши конференции, которые посвящены центрам обработки данных MicroSoft, и проводятся в этих самых дата-центрах, или использование других средств, например, блоги и спецификации, мы уверены, что обмен передовым опытом имеет первостепенное значение и будет продвигать отрасль вперед.

Today we are sharing our Generation 4 Modular Data Center plan. This is our vision and will be the foundation of our cloud data center infrastructure in the next five years. We believe it is one of the most revolutionary changes to happen to data centers in the last 30 years. Joining me, in writing this blog are Daniel Costello, my director of Data Center Research and Engineering and Christian Belady, principal power and cooling architect. I feel their voices will add significant value to driving understanding around the many benefits included in this new design paradigm.

Сейчас мы хотим поделиться своим планом модульного дата-центра четвертого поколения. Это наше видение и оно будет основанием для инфраструктуры наших облачных дата-центров в ближайшие пять лет. Мы считаем, что это одно из самых революционных изменений в дата-центрах за последние 30 лет. Вместе со мной в написании этого блога участвовали Дэниел Костелло, директор по исследованиям и инжинирингу дата-центров, и Кристиан Белади, главный архитектор систем энергоснабжения и охлаждения. Мне кажется, что их авторитет придаст больше веса большому количеству преимуществ, включенных в эту новую парадигму проектирования.

Our “Gen 4” modular data centers will take the flexibility of containerized servers—like those in our Chicago data center—and apply it across the entire facility. So what do we mean by modular? Think of it like “building blocks”, where the data center will be composed of modular units of prefabricated mechanical, electrical, security components, etc., in addition to containerized servers.

Was there a key driver for the Generation 4 Data Center?Наши модульные дата-центры “Gen 4” будут гибкими с контейнерами серверов – как серверы в нашем чикагском дата-центре. И гибкость будет применяться ко всему ЦОД. Итак, что мы подразумеваем под модульностью? Мы думаем о ней как о “строительных блоках”, где дата-центр будет состоять из модульных блоков изготовленных в заводских условиях электрических систем и систем охлаждения, а также систем безопасности и т.п., в дополнение к контейнеризованным серверам.

Был ли ключевой стимул для разработки дата-центра четвертого поколения?

If we were to summarize the promise of our Gen 4 design into a single sentence it would be something like this: “A highly modular, scalable, efficient, just-in-time data center capacity program that can be delivered anywhere in the world very quickly and cheaply, while allowing for continued growth as required.” Sounds too good to be true, doesn’t it? Well, keep in mind that these concepts have been in initial development and prototyping for over a year and are based on cumulative knowledge of previous facility generations and the advances we have made since we began our investments in earnest on this new design.Если бы нам нужно было обобщить достоинства нашего проекта Gen 4 в одном предложении, это выглядело бы следующим образом: “Центр обработки данных с высоким уровнем модульности, расширяемости, и энергетической эффективности, а также возможностью постоянного расширения, в случае необходимости, который можно очень быстро и дешево развертывать в любом месте мира”. Звучит слишком хорошо для того чтобы быть правдой, не так ли? Ну, не забывайте, что эти концепции находились в процессе начальной разработки и создания опытного образца в течение более одного года и основываются на опыте, накопленном в ходе развития предыдущих поколений ЦОД, а также успехах, сделанных нами со времени, когда мы начали вкладывать серьезные средства в этот новый проект.

One of the biggest challenges we’ve had at Microsoft is something Mike likes to call the ‘Goldilock’s Problem’. In a nutshell, the problem can be stated as:

The worst thing we can do in delivering facilities for the business is not have enough capacity online, thus limiting the growth of our products and services.Одну из самых больших проблем, с которыми приходилось сталкиваться Майкрософт, Майк любит называть ‘Проблемой Лютика’. Вкратце, эту проблему можно выразить следующим образом:

Самое худшее, что может быть при строительстве ЦОД для бизнеса, это не располагать достаточными производственными мощностями, и тем самым ограничивать рост наших продуктов и сервисов.The second worst thing we can do in delivering facilities for the business is to have too much capacity online.

А вторым самым худшим моментом в этой сфере может слишком большое количество производственных мощностей.

This has led to a focus on smart, intelligent growth for the business — refining our overall demand picture. It can’t be too hot. It can’t be too cold. It has to be ‘Just Right!’ The capital dollars of investment are too large to make without long term planning. As we struggled to master these interesting challenges, we had to ensure that our technological plan also included solutions for the business and operational challenges we faced as well.

So let’s take a high level look at our Generation 4 designЭто заставило нас сосредоточиваться на интеллектуальном росте для бизнеса — refining our overall demand picture. Это не должно быть слишком горячим. И это не должно быть слишком холодным. Это должно быть ‘как раз, таким как надо!’ Нельзя делать такие большие капиталовложения без долгосрочного планирования. Пока мы старались решить эти интересные проблемы, мы должны были гарантировать, что наш технологический план будет также включать решения для коммерческих и эксплуатационных проблем, с которыми нам также приходилось сталкиваться.

Давайте рассмотрим наш проект дата-центра четвертого поколенияAre you ready for some great visuals? Check out this video at Soapbox. Click here for the Microsoft 4th Gen Video.

It’s a concept video that came out of my Data Center Research and Engineering team, under Daniel Costello, that will give you a view into what we think is the future.

From a configuration, construct-ability and time to market perspective, our primary goals and objectives are to modularize the whole data center. Not just the server side (like the Chicago facility), but the mechanical and electrical space as well. This means using the same kind of parts in pre-manufactured modules, the ability to use containers, skids, or rack-based deployments and the ability to tailor the Redundancy and Reliability requirements to the application at a very specific level.

Посмотрите это видео, перейдите по ссылке для просмотра видео о Microsoft 4th Gen:

Это концептуальное видео, созданное командой отдела Data Center Research and Engineering, возглавляемого Дэниелом Костелло, которое даст вам наше представление о будущем.

С точки зрения конфигурации, строительной технологичности и времени вывода на рынок, нашими главными целями и задачами агрегатирование всего дата-центра. Не только серверную часть, как дата-центр в Чикаго, но также системы охлаждения и электрические системы. Это означает применение деталей одного типа в сборных модулях, возможность использования контейнеров, салазок, или стоечных систем, а также возможность подстраивать требования избыточности и надежности для данного приложения на очень специфичном уровне.Our goals from a cost perspective were simple in concept but tough to deliver. First and foremost, we had to reduce the capital cost per critical Mega Watt by the class of use. Some applications can run with N-level redundancy in the infrastructure, others require a little more infrastructure for support. These different classes of infrastructure requirements meant that optimizing for all cost classes was paramount. At Microsoft, we are not a one trick pony and have many Online products and services (240+) that require different levels of operational support. We understand that and ensured that we addressed it in our design which will allow us to reduce capital costs by 20%-40% or greater depending upon class.

Нашими целями в области затрат были концептуально простыми, но трудно реализуемыми. В первую очередь мы должны были снизить капитальные затраты в пересчете на один мегаватт, в зависимости от класса резервирования. Некоторые приложения могут вполне работать на базе инфраструктуры с резервированием на уровне N, то есть без резервирования, а для работы других приложений требуется больше инфраструктуры. Эти разные классы требований инфраструктуры подразумевали, что оптимизация всех классов затрат имеет преобладающее значение. В Майкрософт мы не ограничиваемся одним решением и располагаем большим количеством интерактивных продуктов и сервисов (240+), которым требуются разные уровни эксплуатационной поддержки. Мы понимаем это, и учитываем это в своем проекте, который позволит нам сокращать капитальные затраты на 20%-40% или более в зависимости от класса.For example, non-critical or geo redundant applications have low hardware reliability requirements on a location basis. As a result, Gen 4 can be configured to provide stripped down, low-cost infrastructure with little or no redundancy and/or temperature control. Let’s say an Online service team decides that due to the dramatically lower cost, they will simply use uncontrolled outside air with temperatures ranging 10-35 C and 20-80% RH. The reality is we are already spec-ing this for all of our servers today and working with server vendors to broaden that range even further as Gen 4 becomes a reality. For this class of infrastructure, we eliminate generators, chillers, UPSs, and possibly lower costs relative to traditional infrastructure.

Например, некритичные или гео-избыточные системы имеют низкие требования к аппаратной надежности на основе местоположения. В результате этого, Gen 4 можно конфигурировать для упрощенной, недорогой инфраструктуры с низким уровнем (или вообще без резервирования) резервирования и / или температурного контроля. Скажем, команда интерактивного сервиса решает, что, в связи с намного меньшими затратами, они будут просто использовать некондиционированный наружный воздух с температурой 10-35°C и влажностью 20-80% RH. В реальности мы уже сегодня предъявляем эти требования к своим серверам и работаем с поставщиками серверов над еще большим расширением диапазона температур, так как наш модуль и подход Gen 4 становится реальностью. Для подобного класса инфраструктуры мы удаляем генераторы, чиллеры, ИБП, и, возможно, будем предлагать более низкие затраты, по сравнению с традиционной инфраструктурой.

Applications that demand higher level of redundancy or temperature control will use configurations of Gen 4 to meet those needs, however, they will also cost more (but still less than traditional data centers). We see this cost difference driving engineering behavioral change in that we predict more applications will drive towards Geo redundancy to lower costs.

Системы, которым требуется более высокий уровень резервирования или температурного контроля, будут использовать конфигурации Gen 4, отвечающие этим требованиям, однако, они будут также стоить больше. Но все равно они будут стоить меньше, чем традиционные дата-центры. Мы предвидим, что эти различия в затратах будут вызывать изменения в методах инжиниринга, и по нашим прогнозам, это будет выражаться в переходе все большего числа систем на гео-избыточность и меньшие затраты.

Another cool thing about Gen 4 is that it allows us to deploy capacity when our demand dictates it. Once finalized, we will no longer need to make large upfront investments. Imagine driving capital costs more closely in-line with actual demand, thus greatly reducing time-to-market and adding the capacity Online inherent in the design. Also reduced is the amount of construction labor required to put these “building blocks” together. Since the entire platform requires pre-manufacture of its core components, on-site construction costs are lowered. This allows us to maximize our return on invested capital.

Еще одно достоинство Gen 4 состоит в том, что он позволяет нам разворачивать дополнительные мощности, когда нам это необходимо. Как только мы закончим проект, нам больше не нужно будет делать большие начальные капиталовложения. Представьте себе возможность более точного согласования капитальных затрат с реальными требованиями, и тем самым значительного снижения времени вывода на рынок и интерактивного добавления мощностей, предусматриваемого проектом. Также снижен объем строительных работ, требуемых для сборки этих “строительных блоков”. Поскольку вся платформа требует предварительного изготовления ее базовых компонентов, затраты на сборку также снижены. Это позволит нам увеличить до максимума окупаемость своих капиталовложений.

Мы все подвергаем сомнениюIn our design process, we questioned everything. You may notice there is no roof and some might be uncomfortable with this. We explored the need of one and throughout our research we got some surprising (positive) results that showed one wasn’t needed.

В своем процессе проектирования мы все подвергаем сомнению. Вы, наверное, обратили внимание на отсутствие крыши, и некоторым специалистам это могло не понравиться. Мы изучили необходимость в крыше и в ходе своих исследований получили удивительные результаты, которые показали, что крыша не нужна.

Серийное производство дата центров

In short, we are striving to bring Henry Ford’s Model T factory to the data center. http://en.wikipedia.org/wiki/Henry_Ford#Model_T. Gen 4 will move data centers from a custom design and build model to a commoditized manufacturing approach. We intend to have our components built in factories and then assemble them in one location (the data center site) very quickly. Think about how a computer, car or plane is built today. Components are manufactured by different companies all over the world to a predefined spec and then integrated in one location based on demands and feature requirements. And just like Henry Ford’s assembly line drove the cost of building and the time-to-market down dramatically for the automobile industry, we expect Gen 4 to do the same for data centers. Everything will be pre-manufactured and assembled on the pad.Мы хотим применить модель автомобильной фабрики Генри Форда к дата-центру. Проект Gen 4 будет способствовать переходу от модели специализированного проектирования и строительства к товарно-производственному, серийному подходу. Мы намерены изготавливать свои компоненты на заводах, а затем очень быстро собирать их в одном месте, в месте строительства дата-центра. Подумайте о том, как сегодня изготавливается компьютер, автомобиль или самолет. Компоненты изготавливаются по заранее определенным спецификациям разными компаниями во всем мире, затем собираются в одном месте на основе спроса и требуемых характеристик. И точно так же как сборочный конвейер Генри Форда привел к значительному уменьшению затрат на производство и времени вывода на рынок в автомобильной промышленности, мы надеемся, что Gen 4 сделает то же самое для дата-центров. Все будет предварительно изготавливаться и собираться на месте.

Невероятно энергоэффективный ЦОД

And did we mention that this platform will be, overall, incredibly energy efficient? From a total energy perspective not only will we have remarkable PUE values, but the total cost of energy going into the facility will be greatly reduced as well. How much energy goes into making concrete? Will we need as much of it? How much energy goes into the fuel of the construction vehicles? This will also be greatly reduced! A key driver is our goal to achieve an average PUE at or below 1.125 by 2012 across our data centers. More than that, we are on a mission to reduce the overall amount of copper and water used in these facilities. We believe these will be the next areas of industry attention when and if the energy problem is solved. So we are asking today…“how can we build a data center with less building”?А мы упоминали, что эта платформа будет, в общем, невероятно энергоэффективной? С точки зрения общей энергии, мы получим не только поразительные значения PUE, но общая стоимость энергии, затраченной на объект будет также значительно снижена. Сколько энергии идет на производство бетона? Нам нужно будет столько энергии? Сколько энергии идет на питание инженерных строительных машин? Это тоже будет значительно снижено! Главным стимулом является достижение среднего PUE не больше 1.125 для всех наших дата-центров к 2012 году. Более того, у нас есть задача сокращения общего количества меди и воды в дата-центрах. Мы думаем, что эти задачи станут следующей заботой отрасли после того как будет решена энергетическая проблема. Итак, сегодня мы спрашиваем себя…“как можно построить дата-центр с меньшим объемом строительных работ”?

Строительство дата центров без чиллеровWe have talked openly and publicly about building chiller-less data centers and running our facilities using aggressive outside economization. Our sincerest hope is that Gen 4 will completely eliminate the use of water. Today’s data centers use massive amounts of water and we see water as the next scarce resource and have decided to take a proactive stance on making water conservation part of our plan.

Мы открыто и публично говорили о строительстве дата-центров без чиллеров и активном использовании в наших центрах обработки данных технологий свободного охлаждения или фрикулинга. Мы искренне надеемся, что Gen 4 позволит полностью отказаться от использования воды. Современные дата-центры расходуют большие объемы воды и так как мы считаем воду следующим редким ресурсом, мы решили принять упреждающие меры и включить экономию воды в свой план.

By sharing this with the industry, we believe everyone can benefit from our methodology. While this concept and approach may be intimidating (or downright frightening) to some in the industry, disclosure ultimately is better for all of us.

Делясь этим опытом с отраслью, мы считаем, что каждый сможет извлечь выгоду из нашей методологией. Хотя эта концепция и подход могут показаться пугающими (или откровенно страшными) для некоторых отраслевых специалистов, раскрывая свои планы мы, в конечном счете, делаем лучше для всех нас.

Gen 4 design (even more than just containers), could reduce the ‘religious’ debates in our industry. With the central spine infrastructure in place, containers or pre-manufactured server halls can be either AC or DC, air-side economized or water-side economized, or not economized at all (though the sanity of that might be questioned). Gen 4 will allow us to decommission, repair and upgrade quickly because everything is modular. No longer will we be governed by the initial decisions made when constructing the facility. We will have almost unlimited use and re-use of the facility and site. We will also be able to use power in an ultra-fluid fashion moving load from critical to non-critical as use and capacity requirements dictate.

Проект Gen 4 позволит уменьшить ‘религиозные’ споры в нашей отрасли. Располагая базовой инфраструктурой, контейнеры или сборные серверные могут оборудоваться системами переменного или постоянного тока, воздушными или водяными экономайзерами, или вообще не использовать экономайзеры. Хотя можно подвергать сомнению разумность такого решения. Gen 4 позволит нам быстро выполнять работы по выводу из эксплуатации, ремонту и модернизации, поскольку все будет модульным. Мы больше не будем руководствоваться начальными решениями, принятыми во время строительства дата-центра. Мы сможем использовать этот дата-центр и инфраструктуру в течение почти неограниченного периода времени. Мы также сможем применять сверхгибкие методы использования электрической энергии, переводя оборудование в режимы критической или некритической нагрузки в соответствии с требуемой мощностью.

Gen 4 – это стандартная платформаFinally, we believe this is a big game changer. Gen 4 will provide a standard platform that our industry can innovate around. For example, all modules in our Gen 4 will have common interfaces clearly defined by our specs and any vendor that meets these specifications will be able to plug into our infrastructure. Whether you are a computer vendor, UPS vendor, generator vendor, etc., you will be able to plug and play into our infrastructure. This means we can also source anyone, anywhere on the globe to minimize costs and maximize performance. We want to help motivate the industry to further innovate—with innovations from which everyone can reap the benefits.

Наконец, мы уверены, что это будет фактором, который значительно изменит ситуацию. Gen 4 будет представлять собой стандартную платформу, которую отрасль сможет обновлять. Например, все модули в нашем Gen 4 будут иметь общепринятые интерфейсы, четко определяемые нашими спецификациями, и оборудование любого поставщика, которое отвечает этим спецификациям можно будет включать в нашу инфраструктуру. Независимо от того производите вы компьютеры, ИБП, генераторы и т.п., вы сможете включать свое оборудование нашу инфраструктуру. Это означает, что мы также сможем обеспечивать всех, в любом месте земного шара, тем самым сводя до минимума затраты и максимальной увеличивая производительность. Мы хотим создать в отрасли мотивацию для дальнейших инноваций – инноваций, от которых каждый сможет получать выгоду.

Главные характеристики дата-центров четвертого поколения Gen4To summarize, the key characteristics of our Generation 4 data centers are:

Scalable

Plug-and-play spine infrastructure

Factory pre-assembled: Pre-Assembled Containers (PACs) & Pre-Manufactured Buildings (PMBs)

Rapid deployment

De-mountable

Reduce TTM

Reduced construction

Sustainable measuresНиже приведены главные характеристики дата-центров четвертого поколения Gen 4:

Расширяемость;

Готовая к использованию базовая инфраструктура;

Изготовление в заводских условиях: сборные контейнеры (PAC) и сборные здания (PMB);

Быстрота развертывания;

Возможность демонтажа;

Снижение времени вывода на рынок (TTM);

Сокращение сроков строительства;

Экологичность;Map applications to DC Class

We hope you join us on this incredible journey of change and innovation!

Long hours of research and engineering time are invested into this process. There are still some long days and nights ahead, but the vision is clear. Rest assured however, that we as refine Generation 4, the team will soon be looking to Generation 5 (even if it is a bit farther out). There is always room to get better.

Использование систем электропитания постоянного тока.

Мы надеемся, что вы присоединитесь к нам в этом невероятном путешествии по миру изменений и инноваций!

На этот проект уже потрачены долгие часы исследований и проектирования. И еще предстоит потратить много дней и ночей, но мы имеем четкое представление о конечной цели. Однако будьте уверены, что как только мы доведем до конца проект модульного дата-центра четвертого поколения, мы вскоре начнем думать о проекте дата-центра пятого поколения. Всегда есть возможность для улучшений.So if you happen to come across Goldilocks in the forest, and you are curious as to why she is smiling you will know that she feels very good about getting very close to ‘JUST RIGHT’.

Generations of Evolution – some background on our data center designsТак что, если вы встретите в лесу девочку по имени Лютик, и вам станет любопытно, почему она улыбается, вы будете знать, что она очень довольна тем, что очень близко подошла к ‘ОПИМАЛЬНОМУ РЕШЕНИЮ’.

Поколения эволюции – история развития наших дата-центровWe thought you might be interested in understanding what happened in the first three generations of our data center designs. When Ray Ozzie wrote his Software plus Services memo it posed a very interesting challenge to us. The winds of change were at ‘tornado’ proportions. That “plus Services” tag had some significant (and unstated) challenges inherent to it. The first was that Microsoft was going to evolve even further into an operations company. While we had been running large scale Internet services since 1995, this development lead us to an entirely new level. Additionally, these “services” would span across both Internet and Enterprise businesses. To those of you who have to operate “stuff”, you know that these are two very different worlds in operational models and challenges. It also meant that, to achieve the same level of reliability and performance required our infrastructure was going to have to scale globally and in a significant way.

Мы подумали, что может быть вам будет интересно узнать историю первых трех поколений наших центров обработки данных. Когда Рэй Оззи написал свою памятную записку Software plus Services, он поставил перед нами очень интересную задачу. Ветра перемен двигались с ураганной скоростью. Это окончание “plus Services” скрывало в себе какие-то значительные и неопределенные задачи. Первая заключалась в том, что Майкрософт собиралась в еще большей степени стать операционной компанией. Несмотря на то, что мы управляли большими интернет-сервисами, начиная с 1995 г., эта разработка подняла нас на абсолютно новый уровень. Кроме того, эти “сервисы” охватывали интернет-компании и корпорации. Тем, кому приходится всем этим управлять, известно, что есть два очень разных мира в области операционных моделей и задач. Это также означало, что для достижения такого же уровня надежности и производительности требовалось, чтобы наша инфраструктура располагала значительными возможностями расширения в глобальных масштабах.

It was that intense atmosphere of change that we first started re-evaluating data center technology and processes in general and our ideas began to reach farther than what was accepted by the industry at large. This was the era of Generation 1. As we look at where most of the world’s data centers are today (and where our facilities were), it represented all the known learning and design requirements that had been in place since IBM built the first purpose-built computer room. These facilities focused more around uptime, reliability and redundancy. Big infrastructure was held accountable to solve all potential environmental shortfalls. This is where the majority of infrastructure in the industry still is today.

Именно в этой атмосфере серьезных изменений мы впервые начали переоценку ЦОД-технологий и технологий вообще, и наши идеи начали выходить за пределы общепринятых в отрасли представлений. Это была эпоха ЦОД первого поколения. Когда мы узнали, где сегодня располагается большинство мировых дата-центров и где находятся наши предприятия, это представляло весь опыт и навыки проектирования, накопленные со времени, когда IBM построила первую серверную. В этих ЦОД больше внимания уделялось бесперебойной работе, надежности и резервированию. Большая инфраструктура была призвана решать все потенциальные экологические проблемы. Сегодня большая часть инфраструктуры все еще находится на этом этапе своего развития.

We soon realized that traditional data centers were quickly becoming outdated. They were not keeping up with the demands of what was happening technologically and environmentally. That’s when we kicked off our Generation 2 design. Gen 2 facilities started taking into account sustainability, energy efficiency, and really looking at the total cost of energy and operations.

Очень быстро мы поняли, что стандартные дата-центры очень быстро становятся устаревшими. Они не поспевали за темпами изменений технологических и экологических требований. Именно тогда мы стали разрабатывать ЦОД второго поколения. В этих дата-центрах Gen 2 стали принимать во внимание такие факторы как устойчивое развитие, энергетическая эффективность, а также общие энергетические и эксплуатационные.

No longer did we view data centers just for the upfront capital costs, but we took a hard look at the facility over the course of its life. Our Quincy, Washington and San Antonio, Texas facilities are examples of our Gen 2 data centers where we explored and implemented new ways to lessen the impact on the environment. These facilities are considered two leading industry examples, based on their energy efficiency and ability to run and operate at new levels of scale and performance by leveraging clean hydro power (Quincy) and recycled waste water (San Antonio) to cool the facility during peak cooling months.

Мы больше не рассматривали дата-центры только с точки зрения начальных капитальных затрат, а внимательно следили за работой ЦОД на протяжении его срока службы. Наши объекты в Куинси, Вашингтоне, и Сан-Антонио, Техас, являются образцами наших ЦОД второго поколения, в которых мы изучали и применяли на практике новые способы снижения воздействия на окружающую среду. Эти объекты считаются двумя ведущими отраслевыми примерами, исходя из их энергетической эффективности и способности работать на новых уровнях производительности, основанных на использовании чистой энергии воды (Куинси) и рециклирования отработанной воды (Сан-Антонио) для охлаждения объекта в самых жарких месяцах.

As we were delivering our Gen 2 facilities into steel and concrete, our Generation 3 facilities were rapidly driving the evolution of the program. The key concepts for our Gen 3 design are increased modularity and greater concentration around energy efficiency and scale. The Gen 3 facility will be best represented by the Chicago, Illinois facility currently under construction. This facility will seem very foreign compared to the traditional data center concepts most of the industry is comfortable with. In fact, if you ever sit around in our container hanger in Chicago it will look incredibly different from a traditional raised-floor data center. We anticipate this modularization will drive huge efficiencies in terms of cost and operations for our business. We will also introduce significant changes in the environmental systems used to run our facilities. These concepts and processes (where applicable) will help us gain even greater efficiencies in our existing footprint, allowing us to further maximize infrastructure investments.

Так как наши ЦОД второго поколения строились из стали и бетона, наши центры обработки данных третьего поколения начали их быстро вытеснять. Главными концептуальными особенностями ЦОД третьего поколения Gen 3 являются повышенная модульность и большее внимание к энергетической эффективности и масштабированию. Дата-центры третьего поколения лучше всего представлены объектом, который в настоящее время строится в Чикаго, Иллинойс. Этот ЦОД будет выглядеть очень необычно, по сравнению с общепринятыми в отрасли представлениями о дата-центре. Действительно, если вам когда-либо удастся побывать в нашем контейнерном ангаре в Чикаго, он покажется вам совершенно непохожим на обычный дата-центр с фальшполом. Мы предполагаем, что этот модульный подход будет способствовать значительному повышению эффективности нашего бизнеса в отношении затрат и операций. Мы также внесем существенные изменения в климатические системы, используемые в наших ЦОД. Эти концепции и технологии, если применимо, позволят нам добиться еще большей эффективности наших существующих дата-центров, и тем самым еще больше увеличивать капиталовложения в инфраструктуру.

This is definitely a journey, not a destination industry. In fact, our Generation 4 design has been under heavy engineering for viability and cost for over a year. While the demand of our commercial growth required us to make investments as we grew, we treated each step in the learning as a process for further innovation in data centers. The design for our future Gen 4 facilities enabled us to make visionary advances that addressed the challenges of building, running, and operating facilities all in one concerted effort.

Это определенно путешествие, а не конечный пункт назначения. На самом деле, наш проект ЦОД четвертого поколения подвергался серьезным испытаниям на жизнеспособность и затраты на протяжении целого года. Хотя необходимость в коммерческом росте требовала от нас постоянных капиталовложений, мы рассматривали каждый этап своего развития как шаг к будущим инновациям в области дата-центров. Проект наших будущих ЦОД четвертого поколения Gen 4 позволил нам делать фантастические предположения, которые касались задач строительства, управления и эксплуатации объектов как единого упорядоченного процесса.

Тематики

Синонимы

EN

Русско-английский словарь нормативно-технической терминологии > модульный центр обработки данных (ЦОД)

-

7 большой ЦОД

большой ЦОД

крупный ЦОД

-

[Интент]Тематики

Синонимы

EN

Русско-английский словарь нормативно-технической терминологии > большой ЦОД

-

8 управление инфраструктурой центров обработки данных (ЦОД)

Русско-английский словарь нормативно-технической терминологии > управление инфраструктурой центров обработки данных (ЦОД)

-

9 Комната ИТ-безопасности, предназначенная для организации физической защиты от негативного воздействия внешней среды и обеспечения оптимального функционирования ЦОД

Security: Lampertz IT modular roomУниверсальный русско-английский словарь > Комната ИТ-безопасности, предназначенная для организации физической защиты от негативного воздействия внешней среды и обеспечения оптимального функционирования ЦОД

-

10 управление электропитанием

управление электропитанием

-

[Интент]

Управление электропитанием ЦОД

Автор: Жилкина Наталья

Опубликовано 23 апреля 2009 года

Источники бесперебойного питания, функционирующие в ЦОД, составляют важный элемент общей системы его энергообеспечения. Вписываясь в контур управления ЦОД, система мониторинга и управления ИБП становится ядром для реализации эксплуатационных функций.

Три задачи

Системы мониторинга, диагностики и управления питанием нагрузки решают три основные задачи: позволяют ИБП выполнять свои функции, оповещать персонал о происходящих с ними событиях и посылать команды для автоматического завершения работы защищаемого устройства.

Мониторинг параметров ИБП предполагает отображение и протоколирование состояния устройства и всех событий, связанных с его изменением. Диагностика реализуется функциями самотестирования системы. Управляющие же функции предполагают активное вмешательство в логику работы устройства.Многие специалисты этого рынка, отмечая важность процедуры мониторинга, считают, что управление должно быть сведено к минимуму. «Функция управления ИБП тоже нужна, но скорее факультативно, — говорит Сергей Ермаков, технический директор компании Inelt и эксперт в области систем Chloride. — Я глубоко убежден, что решения об активном управляющем вмешательстве в работу систем защиты электропитания ответственной нагрузки должен принимать человек, а не автоматизированная система. Завершение работы современных мощных серверов, на которых функционируют ответственные приложения, — это, как правило, весьма длительный процесс. ИБП зачастую не способны обеспечивать необходимое для него время, не говоря уж о времени запуска какого-то сервиса». Функция же мониторинга позволяет предотвратить наступление нежелательного события — либо, если таковое произошло, проанализировать его причины, опираясь не на слова, а на запротоколированные данные, хранящиеся в памяти адаптера или файлах на рабочей станции мониторинга.

Эту точку зрения поддерживает и Алексей Сарыгин, технический директор компании Radius Group: «Дистанционное управление мощных ИБП — это вопрос, к которому надо подходить чрезвычайно аккуратно. Если функции дистанционного мониторинга и диспетчеризации необходимы, то практика предоставления доступа персоналу к функциям дистанционного управления представляется радикально неверной. Доступность модулей управления извне потенциально несет в себе риск нарушения безопасности и категорически снижает надежность системы. Если существует физическая возможность дистанционно воздействовать на ИБП, на его параметры, отключение, снятие нагрузки, закрытие выходных тиристорных ключей или блокирование цепи байпаса, то это чревато потерей питания всего ЦОД».

Практически на всех трехфазных ИБП предусмотрена кнопка E.P.O. (Emergency Power Off), дублер которой может быть выведен на пульт управления диспетчерской. Она обеспечивает аварийное дистанционное отключение блоков ИБП при наступлении аварийных событий. Это, пожалуй, единственная возможность обесточить нагрузку, питаемую от трехфазного аппарата, но реализуется она в исключительных случаях.

Что же касается диагностики электропитания, то, как отмечает Юрий Копылов, технический директор московского офиса корпорации Eaton, в последнее время характерной тенденцией в управляющем программном обеспечении стал отказ от предоставления функций удаленного тестирования батарей даже системному администратору.

— Адекватно сравнивать состояние батарей необходимо под нагрузкой, — говорит он, — сам тест запускать не чаще чем раз в два дня, а разряжать батареи надо при одном и том же токе и уровне нагрузки. К тому же процесс заряда — довольно долгий. Все это не идет батареям на пользу.Средства мониторинга

Производители ИБП предоставляют, как правило, сразу несколько средств мониторинга и в некоторых случаях даже управления ИБП — все они основаны на трех основных методах.

В первом случае устройство подключается напрямую через интерфейс RS-232 (Com-порт) к консоли администратора. Дальность такого подключения не превышает 15 метров, но может быть увеличена с помощью конверторов RS-232/485 и RS-485/232 на концах провода, связывающего ИБП с консолью администратора. Такой способ обеспечивает низкую скорость обмена информацией и пригоден лишь для топологии «точка — точка».

Второй способ предполагает использование SNMP-адаптера — встроенной или внешней интерфейсной карты, позволяющей из любой точки локальной сети получить информацию об основных параметрах ИБП. В принципе, для доступа к ИБП через SNMP достаточно веб-браузера. Однако для большего комфорта производители оснащают свои системы более развитым графическим интерфейсом, обеспечивающим функции мониторинга и корректного завершения работы. На базе SNMP-протокола функционируют все основные системы мониторинга и управления ИБП, поставляемые штатно или опционально вместе с ИБП.

Стандартные SNMP-адаптеры поддерживают подключение нескольких аналоговых или пороговых устройств — датчик температуры, движения, открытия двери и проч. Интеграция таких устройств в общую систему мониторинга крупного объекта (например, дата-центра) позволяет охватить огромное количество точек наблюдения и отразить эту информацию на экране диспетчера.

Большое удобство предоставляет метод эксплуатационного удаленного контроля T.SERVICE, позволяющий отследить работу оборудования посредством телефонной линии (через модем GSM) или через Интернет (с помощью интерфейса Net Vision путем рассылки e-mail на электронный адрес потребителя). T.SERVICE обеспечивает диагностирование оборудования в режиме реального времени в течение 24 часов в сутки 365 дней в году. ИБП автоматически отправляет в центр технического обслуживания регулярные отчеты или отчеты при обнаружении неисправности. В зависимости от контролируемых параметров могут отправляться уведомления о неправильной эксплуатации (с пользователем связывается опытный специалист и рекомендует выполнить простые операции для предотвращения ухудшения рабочих характеристик оборудования) или о наличии отказа (пользователь информируется о состоянии устройства, а на место установки немедленно отправляется технический специалист).Профессиональное мнение

Наталья Маркина, коммерческий директор представительства компании SOCOMEC

Управляющее ПО фирмы SOCOMEC легко интегрируется в общий контур управления инженерной инфраструктурой ЦОД посредством разнообразных интерфейсов передачи данных ИБП. Установленное в аппаратной или ЦОД оборудование SOCOMEC может дистанционно обмениваться информацией о своих рабочих параметрах с системами централизованного управления и компьютерными сетями посредством сухих контактов, последовательных портов RS232, RS422, RS485, а также через интерфейс MODBUS TCP и GSS.

Интерфейс GSS предназначен для коммуникации с генераторными установками и включает в себя 4 входа (внешние контакты) и 1 выход (60 В). Это позволяет программировать особые процедуры управления, Global Supply System, которые обеспечивают полную совместимость ИБП с генераторными установками.

У компании Socomec имеется широкий выбор интерфейсов и коммуникационного программного обеспечения для установки диалога между ИБП и удаленными системами мониторинга промышленного и компьютерного оборудования. Такие опции связи, как панель дистанционного управления, интерфейс ADC (реконфигурируемые сухие контакты), обеспечивающий ввод и вывод данных при помощи сигналов сухих контактов, интерфейсы последовательной передачи данных RS232, RS422, RS485 по протоколам JBUS/MODBUS, PROFIBUS или DEVICENET, MODBUS TCP (JBUS/MODBUS-туннелирование), интерфейс NET VISION для локальной сети Ethernet, программное обеспечение TOP VISION для выполнения мониторинга с помощью рабочей станции Windows XP PRO — все это позволяет контролировать работу ИБП удобным для пользователя способом.

Весь контроль управления ИБП, ДГУ, контроль окружающей среды сводится в единый диспетчерский пункт посредством протоколов JBUS/MODBUS.

Индустриальный подход

Третий метод основан на использовании высокоскоростной индустриальной интерфейсной шины: CANBus, JBus, MODBus, PROFIBus и проч. Некоторые модели ИБП поддерживают разновидность универсального smart-слота для установки как карточек SNMP, так и интерфейсной шины. Система мониторинга на базе индустриальной шины может быть интегрирована в уже существующую промышленную SCADA-систему контроля и получения данных либо создана как заказное решение на базе многофункциональных стандартных контроллеров с выходом на шину. Промышленная шина через шлюзы передает информацию на удаленный диспетчерский пункт или в систему управления зданием (Building Management System, BMS). В эту систему могут быть интегрированы и контроллеры, управляющие ИБП.

Универсальные SCADA-системы поддерживают датчики и контроллеры широкого перечня производителей, но они недешевы и к тому же неудобны для внесения изменений. Но если подобная система уже функционирует на объекте, то интеграция в нее дополнительных ИБП не представляет труда.

Сергей Ермаков, технический директор компании Inelt, считает, что применение универсальных систем управления на базе промышленных контроллеров нецелесообразно, если используется для мониторинга только ИБП и ДГУ. Один из практичных подходов — создание заказной системы, с удобной для заказчика графической оболочкой и необходимым уровнем детализации — от карты местности до поэтажного плана и погружения в мнемосхему компонентов ИБП.

— ИБП может передавать одинаковое количество информации о своем состоянии и по прямому соединению, и по SNMP, и по Bus-шине, — говорит Сергей Ермаков. — Применение того или иного метода зависит от конкретной задачи и бюджета. Создав первоначально систему UPS Look для мониторинга ИБП, мы интегрировали в нее систему мониторинга ДГУ на основе SNMP-протокола, после чего по желанию одного из заказчиков конвертировали эту систему на промышленную шину Jbus. Новое ПО JSLook для мониторинга неограниченного количества ИБП и ДГУ по протоколу JBus является полнофункциональным средством мониторинга всей системы электроснабжения объекта.Профессиональное мение

Денис Андреев, руководитель департамента ИБП компании Landata

Практически все ИБП Eaton позволяют использовать коммуникационную Web-SNMP плату Connect UPS и датчик EMP (Environmental Monitoring Probe). Такой комплект позволяет в числе прочего осуществлять мониторинг температуры, влажности и состояния пары «сухих» контактов, к которым можно подключить внешние датчики.

Решение Eaton Environmental Rack Monitor представляет собой аналог такой связки, но с существенно более широким функционалом. Внешне эта система мониторинга температуры, влажности и состояния «сухих» контактов выполнена в виде компактного устройства, которое занимает минимум места в шкафу или в помещении.

Благодаря наличию у Eaton Environmental Rack Monitor (ERM) двух выходов датчики температуры или влажности можно разместить в разных точках стойки или помещения. Поскольку каждый из двух датчиков имеет еще по два сухих контакта, с них дополнительно можно принимать сигналы от датчиков задымления, утечки и проч. В центре обработки данных такая недорогая система ERM, состоящая из неограниченного количества датчиков, может транслировать информацию по протоколу SNMP в HTML-страницу и позволяет, не приобретая специального ПО, получить сводную таблицу измеряемых величин через веб-браузер.

Проблему дефицита пространства и высокой плотности размещения оборудования в серверных и ЦОД решают системы распределения питания линейки Eaton eDPU, которые можно установить как внутри стойки, так и на группу стоек.

Все модели этой линейки представляют четыре семейства: системы базового исполнения, системы с индикацией потребляемого тока, с мониторингом (локальным и удаленным, по сети) и управляемые, с возможностью мониторинга и управления электропитанием вплоть до каждой розетки. С помощью этих устройств можно компактным способом увеличить количество розеток в одной стойке, обеспечить контроль уровня тока и напряжения критичной нагрузки.

Контроль уровня потребляемой мощности может осуществляться с высокой степенью детализации, вплоть до сервера, подключенного к конкретной розетке. Это позволяет выяснить, какой сервер перегревается, где вышел из строя вентилятор, блок питания и т. д. Программным образом можно запустить сервер, подключенный к розетке ePDU. Интеграция системы контроля ePDU в платформу управления Eaton находится в процессе реализации.Требование объекта

Как поясняет Олег Письменский, в критичных объектах, таких как ЦОД, можно условно выделить две области контроля и управления. Первая, Grey Space, — это собственно здание и соответствующая система его энергообеспечения и энергораспределения. Вторая, White Space, — непосредственно машинный зал с его системами.

Выбор системы управления энергообеспечением ЦОД определяется типом объекта, требуемым функционалом системы управления и отведенным на эти цели бюджетом. В большинстве случаев кратковременная задержка между наступлением события и получением информации о нем системой мониторинга по SNMP-протоколу допустима. Тем не менее в целом ряде случаев, если характеристики объекта подразумевают непрерывность его функционирования, объект является комплексным и содержит большое количество элементов, требующих контроля и управления в реальном времени, ни одна стандартная система SNMP-мониторинга не обеспечит требуемого функционала. Для таких объектов применяют системы управления real-time, построенные на базе программно-аппаратных комплексов сбора данных, в том числе c функциями Softlogic.

Системы диспетчеризации и управления крупными объектами реализуются SCADA-системами, широкий перечень которых сегодня присутствует на рынке; представлены они и в портфеле решений Schneider Electric. Тип SCADA-системы зависит от класса и размера объекта, от количества его элементов, требующих контроля и управления, от уровня надежности. Частный вид реализации SCADA — это BMS-система(Building Management System).

«Дата-центры с объемом потребляемой мощности до 1,5 МВт и уровнем надежности Tier I, II и, с оговорками, даже Tier III, могут обслуживаться без дополнительной SCADA-системы, — говорит Олег Письменский. — На таких объектах целесообразно применять ISX Central — программно-аппаратный комплекс, использующий SNMP. Если же категория и мощность однозначно предполагают непрерывность управления, в таких случаях оправданна комбинация SNMP- и SCADA-системы. Например, для машинного зала (White Space) применяется ISX Central с возможными расширениями как Change & Capacity Manager, в комбинации со SCADA-системой, управляющей непосредственно объектом (Grey Space)».Профессиональное мнение

Олег Письменский, директор департамента консалтинга APC by Schneider Electric в России и СНГ

Подход APC by Schneider Electric к реализации полномасштабного полноуправляемого и надежного ЦОД изначально был основан на базисных принципах управления ИТ-инфраструктурой в рамках концепции ITIL/ITSM. И история развития системы управления инфраструктурой ЦОД ISX Manager, которая затем интегрировалась с программно-аппаратным комплексом NetBotz и трансформировалась в портал диспетчеризации ISX Central, — лучшее тому доказательство.

Первым итогом поэтапного приближения к намеченной цели стало наращивание функций контроля параметров энергообеспечения. Затем в этот контур подключилась система управления кондиционированием, система контроля параметров окружающей среды. Очередным шагом стало измерение скорости воздуха, влажности, пыли, радиации, интеграция сигналов от камер аудио- и видеонаблюдения, системы управления блоками розеток, завершения работы сервера и т. д.

Эта система не может и не должна отвечать абсолютно всем принципам ITSM, потому что не все они касаются существа поставленной задачи. Но как только в отношении политик и некоторых тактик управления емкостью и изменениями в ЦОД потребовался соответствующий инструментарий — это нашло отражение в расширении функционала ISX Central, который в настоящее время реализуют ПО APC by Schneider Electric Capacity Manager и APC by Schneider Electric Change Manager. С появлением этих двух решений, интегрированных в систему управления реальным объектом, АРС предоставляет возможность службе эксплуатации оптимально планировать изменения количественного и качественного состава оборудования машинного зала — как на ежедневном оперативном уровне, так и на уровне стратегических задач массовых будущих изменений.

Решение APC by Schneider Electric Capacity обеспечивает автоматизированную обработку информации о свободных ресурсах инженерной инфраструктуры, реальном потреблении мощности и пространстве в стойках. Обращаясь к серверу ISX Central, системы APC by Schneider Electric Capacity Manager и APC by Schneider Electric Change Manager оценивают степень загрузки ИБП и систем охлаждения InRow, прогнозируют воздействие предполагаемых изменений и предлагают оптимальное место для установки нового или перестановки имеющегося оборудования. Новые решения позволяют, выявив последствия от предполагаемых изменений, правильно спланировать замену оборудования в ЦОД.

Переход от частного к общему может потребовать интеграции ISX Central в такие, например, порталы управления, как Tivoli или Open View. Возможны и другие сценарии, когда ISX Central вписывается и в SCADA–систему. В этом случае ISX Central выполняет роль диспетчерской настройки, функционал которой распространяется на серверную комнату, но не охватывает целиком периметр объекта.Случай из практики

Решение задачи управления энергообеспечением ЦОД иногда вступает в противоречие с правилами устройств электроустановок (ПУЭ). Может оказаться, что в соответствии с ПУЭ в ряде случаев (например, при компоновке щитов ВРУ) необходимо обеспечить механические блокировки. Однако далеко не всегда это удается сделать. Поэтому такая задача часто требует нетривиального решения.

— В одном из проектов, — вспоминает Алексей Сарыгин, — где система управления включала большое количество точек со взаимными пересечениями блокировок, требовалось не допустить снижения общей надежности системы. В этом случае мы пришли к осознанному компромиссу, сделали систему полуавтоматической. Там, где это было возможно, присутствовали механические блокировки, за пультом дежурной смены были оставлены функции мониторинга и анализа, куда сводились все данные о положении всех автоматов. Но исполнительную часть вывели на отдельную панель управления уже внутри ВРУ, где были расположены подробные пользовательские инструкции по оперативному переключению. Таким образом мы избавились от излишней автоматизации, но постарались минимизировать потери в надежности и защититься от ошибок персонала.

[ http://www.computerra.ru/cio/old/products/infrastructure/421312/]Тематики

EN

Русско-английский словарь нормативно-технической терминологии > управление электропитанием

-

11 система охлаждения ЦОДа

система охлаждения ЦОДа

-

[Интент]т

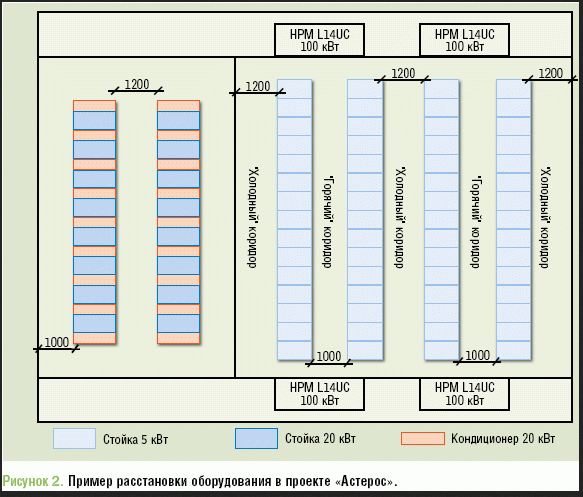

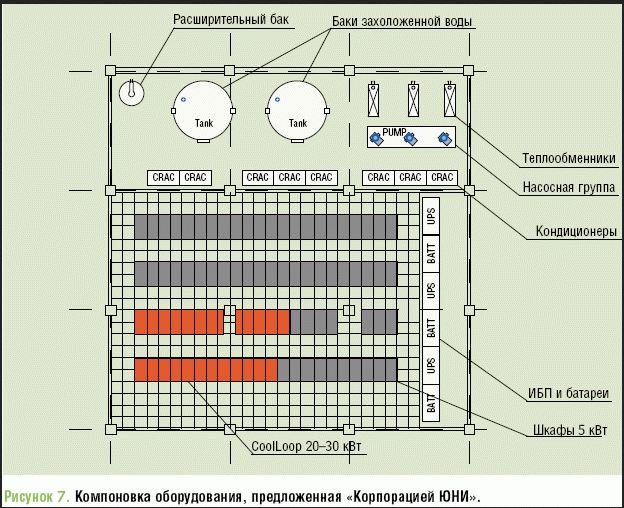

Система охлаждения для небольшого ЦОДаВымышленная компания (далее Заказчик) попросила предложить систему охлаждения для строящегося коммерческого ЦОДа. В основном зале планируется установить:

- 60 стоек с энергопотреблением по 5 кВт (всего 300 кВт) — все элементы, необходимые для обеспечения требуемой температуры и влажности, должны быть установлены сразу;

- 16 стоек с энергопотреблением по 20 кВт (всего 320 кВт) — это оборудование будет устанавливаться постепенно (по мере необходимости), и средства охлаждения планируется развертывать и задействовать по мере подключения и загрузки стоек.

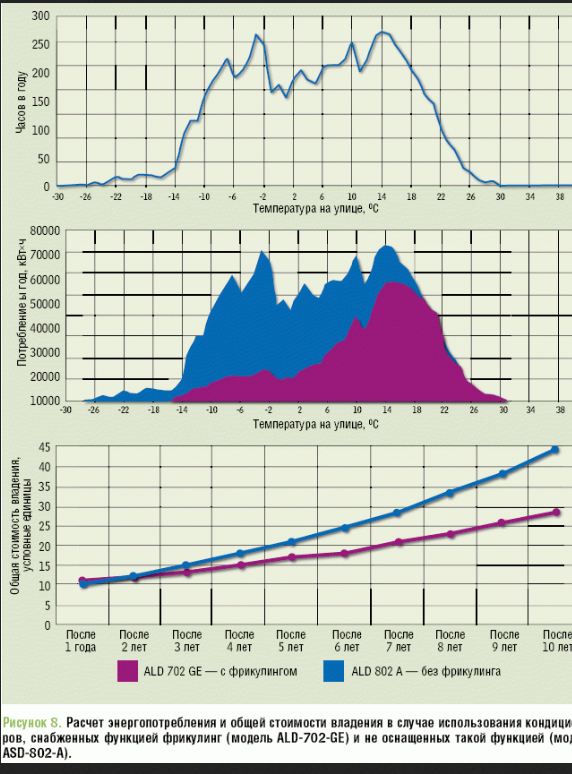

Заказчик заявил, что предпочтение будет отдано энергоэффективным решениям, поэтому желательно задействовать «зеленые» технологии, в первую очередь фрикулинг (естественное охлаждение наружным воздухом — free cooling), и предоставить расчет окупаемости соответствующей опции (с учетом того, что объект находится в Московской области). Планируемый уровень резервирования — N+1, но возможны и другие варианты — при наличии должного обоснования. Кроме того, Заказчик попросил изначально предусмотреть средства мониторинга энергопотребления с целью оптимизации расхода электроэнергии.

ЧТО ПРОГЛЯДЕЛ ЗАКАЗЧИК

В сформулированной в столь общем виде задаче не учтен ряд существенных деталей, на которые не преминули указать эксперты. Так, Дмитрий Чагаров, руководитель направления вентиляции и кондиционирования компании «Утилекс», заметил, что в задании ничего не сказано о характере нагрузки. Он, как и остальные проектировщики, исходил из предположения, что воздушный поток направлен с фронтальной части стоек назад, но, как известно, некоторые коммутаторы спроектированы для охлаждения сбоку — для них придется использовать специальные боковые блоки распределения воздушного потока.

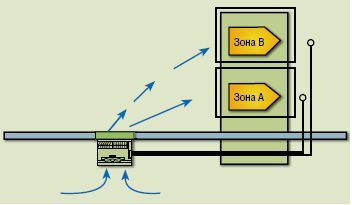

В задании сказано о размещении всех стоек (5 и 20 кВт) в основном зале, однако некоторые эксперты настоятельно рекомендуют выделить отдельную зону для высоконагруженных стоек. По словам Александра Мартынюка, генерального директора консалтинговой компании «Ди Си квадрат», «это будет правильнее и с точки зрения проектирования, и с позиций удобства эксплуатации». Такое выделение (изоляция осуществляется при помощи выгородок) предусмотрено, например, в проекте компании «Комплит»: Владислав Яковенко, начальник отдела инфраструктурных проектов, уверен, что подобное решение, во-первых, облегчит обслуживание оборудования, а во-вторых, позволит использовать различные технологии холодоснабжения в разных зонах. Впрочем, большинство проектировщиков не испытали особых проблем при решении задачи по отводу тепла от стоек 5 и 20 кВт, установленных в одном помещении.

Один из первых вопросов, с которым Заказчик обратился к будущему партнеру, был связан с фальшполом: «Необходим ли он вообще, и если нужен, то какой высоты?». Александр Мартынюк указал, что грамотный расчет высоты фальшпола возможен только при условии предоставления дополнительной информации: о типе стоек (как в них будет организована подача охлаждающего воздуха?); об организации кабельной проводки (под полом или потолком? сколько кабелей? какого диаметра?); об особенностях помещения (высота потолков, соотношение длин стен, наличие выступов и опорных колонн) и т. д. Он советует выполнить температурно-климатическое моделирование помещения с учетом вышеперечисленных параметров и, если потребуется, уточняющих данных. В результате можно будет подготовить рекомендации в отношении оптимальной высоты фальшпола, а также дать оценку целесообразности размещения в одном зале стоек с разной энергонагруженностью.

Что ж, мы действительно не предоставили всей информации, необходимой для подобного моделирования, и проектировщикам пришлось довольствоваться скудными исходными данными. И все же, надеемся, представленные решения окажутся интересными и полезными широкому кругу заказчиков. Им останется только «подогнать» решения «под себя».

«КЛАССИКА» ОХЛАЖДЕНИЯ

Для снятия тепла со стоек при нагрузке 5 кВт большинство проектировщиков предложили самый распространенный на сегодня вариант — установку шкафных прецизионных кондиционеров, подающих холодный воздух в пространство под фальшполом. Подвод воздуха к оборудованию осуществляется в зоне холодных коридоров через перфорированные плиты или воздухораспределительные решетки фальшпола, а отвод воздуха от кондиционеров — из зоны горячих коридоров через верхнюю часть зала или пространство навесного потолка (см. Рисунок 1). Такая схема может быть реализована только при наличии фальшпола достаточной высоты

В вопросе выбора места для установки шкафных кондиционеров единство мнений отсутствует, многие указали на возможность их размещения как в серверном зале, так и в соседнем помещении. Алексей Карпинский, директор департамента инженерных систем компании «Астерос», уверен, что для низконагруженных стоек лучшим решением будет вынос «тяжелой инженерии» за пределы серверного зала (см. Рисунок 2) — тогда для обслуживания кондиционеров внутрь зала входить не придется. «Это повышает надежность работы оборудования, ведь, как известно, наиболее часто оно выходит из строя вследствие человеческого фактора, — объясняет он. — Причем помещение с кондиционерами может быть совершенно не связанным с машинным залом и располагаться, например, через коридор или на другом этаже».

Если стойки мощностью 5 и 20 кВт устанавливаются в одном помещении, Александр Ласый, заместитель директора департамента интеллектуальных зданий компании «Крок», рекомендует организовать физическое разделение горячих и холодных коридоров. В ситуации, когда для высоконагруженных стоек выделяется отдельное помещение, подобного разделения для стоек на 5 кВт не требуется.

ФРЕОН ИЛИ ВОДА

Шкафные кондиционеры на рынке представлены как во фреоновом исполнении, так и в вариантах с водяным охлаждением. При использовании фреоновых кондиционеров на крыше или прилегающей территории необходимо предусмотреть место для установки конденсаторных блоков, а при водяном охлаждении потребуется место под насосную и водоохлаждающие машины (чиллеры).

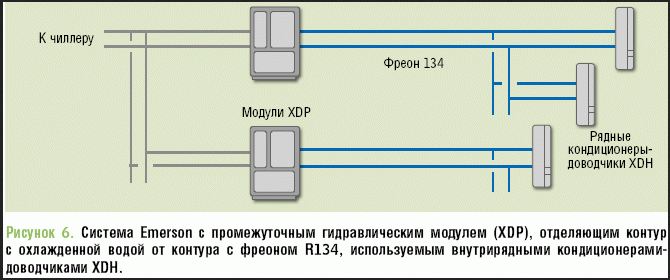

Специалисты компании «АМДтехнологии» представили Заказчику сравнение различных вариантов фреоновых и водяных систем кондиционирования. Наиболее бюджетный вариант предусматривает установку обычных шкафных фреоновых кондиционеров HPM M50 UA с подачей холодного воздуха под фальшпол. Примерно на четверть дороже обойдутся модели кондиционеров с цифровым спиральным компрессором и электронным терморасширительным вентилем (HPM D50 UA, Digital). Мощность кондиционеров регулируется в зависимости от температуры в помещении, это позволяет добиться 12-процентной экономии электроэнергии, а также уменьшить количество пусков и останова компрессора, что повышает срок службы системы. В случае отсутствия на объекте фальшпола (или его недостаточной высоты) предложен более дорогой по начальным вложениям, но экономичный в эксплуатации вариант с внутрирядными фреоновыми кондиционерами.

Как показывает представленный анализ, фреоновые кондиционеры менее эффективны по сравнению с системой водяного охлаждения. При этом, о чем напоминает Виктор Гаврилов, технический директор «АМДтехнологий», фреоновая система имеет ограничение по длине трубопровода и перепаду высот между внутренними и наружными блоками (эквивалентная общая длина трассы фреонопровода не должна превышать 50 м, а рекомендуемый перепад по высоте — 30 м); у водяной системы таких ограничений нет, поэтому ее можно приспособить к любым особенностям здания и прилегающей территории. Важно также помнить, что при применении фреоновой системы перспективы развития (увеличение плотности энергопотребления) существенно ограничены, тогда как при закладке необходимой инфраструктуры подачи холодной воды к стойкам (трубопроводы, насосы, арматура) нагрузку на стойку можно впоследствии увеличивать до 30 кВт и выше, не прибегая к капитальной реконструкции серверного помещения.

К факторам, которые могут определить выбор в пользу фреоновых кондиционеров, можно отнести отсутствие места на улице (например из-за невозможности обеспечить пожарный проезд) или на кровле (вследствие особенностей конструкции или ее недостаточной несущей способности) для монтажа моноблочных чиллеров наружной установки. При этом большинство экспертов единодушно высказывают мнение, что при указанных мощностях решение на воде экономически целесообразнее и проще в реализации. Кроме того, при использовании воды и/или этиленгликолевой смеси в качестве холодоносителя можно задействовать типовые функции фрикулинга в чиллерах.

Впрочем, функции фрикулинга возможно задействовать и во фреоновых кондиционерах. Такие варианты указаны в предложениях компаний RC Group и «Инженерное бюро ’’Хоссер‘‘», где используются фреоновые кондиционеры со встроенными конденсаторами водяного охлаждения и внешними теплообменниками с функцией фрикулинга (сухие градирни). Специалисты RC Group сразу отказались от варианта с установкой кондиционеров с выносными конденсаторами воздушного охлаждения, поскольку он не соответствует требованию Заказчика задействовать режим фрикулинга. Помимо уже названного они предложили решение на основе кондиционеров, работающих на охлажденной воде. Интересно отметить, что и проектировшики «Инженерного бюро ’’Хоссер‘‘» разработали второй вариант на воде.